cs229 笔记 1:线性回归

俗话说好记性不如烂笔头,看过的东西很快就会忘了,记录下来一方面会增强记忆,另一方面也方便查阅。这里根据 css229 视频和讲义简单做下笔记。

监督学习

本节定义了一些符号。

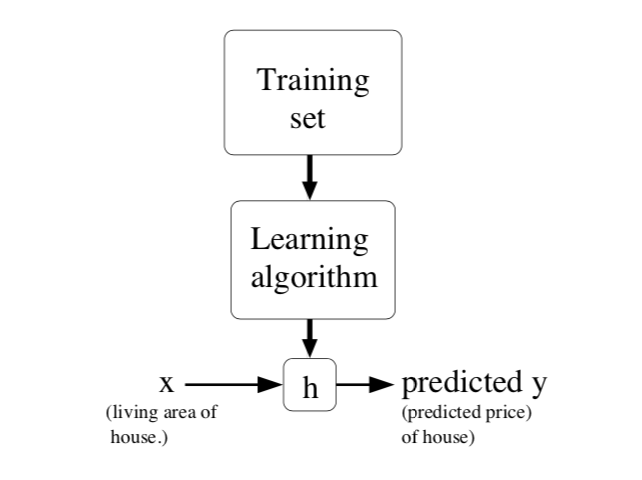

所谓监督学习,可以简单描述为:给定一个训练集,通过训练学习到函数

若预测结果是连续的,把这种学习问题称为 回归问题。若预测结果只有少数几个值,则称为 分类问题。

线性回归

对于监督学习,首先要考虑的是 hypothesis 的形式,线性回归自然用到的是线性函数。例如预测房价问题,

其中

这里

如何求

LMS 算法

为了最小化

其中

只考虑一个样本,更新规则如下

此更新规则叫做 **LMS **(least mean squares) 更新规则,或 Widrow-Hoff learning rule。其中

稍作修改可应用于整个训练集。对于每一个参数

批梯度下降每次迭代需要对样本集中的所有样本进行计算,当样本集比较大时,计算量也会相应的变得比较大,甚至难以实现。此时可使用 ** 随机梯度下降 **(stochastic gradient descent),每次迭代随机选取一个样本进行训练。使用随机梯度下降可以快速收敛到接近最小值,通常是在最小值附近波动。当样本集非常大时通常选用随机梯度下降法

概率解释

为什么选用 least-squares 损失函数作为线性回归的损失函数?实际上,在做出几个概率假设的条件下,可以很容易推导出该损失函数

假设输出变量和输入变量之间的关系可以用如下公式表示

其中

可以得到

其中

似然函数 likelihood function

根据独立同分布假设

根据最大似然法,求出使

若要使其最大化,只需要使第二项最小化,也就是使下式最小化。这就是

局部加权线性回归

在原始的线性回归算法中,我们的目标是找到

LWR (Locally weighted linear regression) 算法中,目标是使如下式子最小化

其中

这里权重的大小依赖于

参数

LWR 是非参数化学习算法。所谓参数化 (parametric) 学习算法,即训练出算法的参数后,可以使用算法对新的输入进行结果预测,不需要保留训练集,比如原始的线性回归算法。非参数化 (non-parametric) 学习算法刚好相反,需始终保留训练集

- 2018-07-07

二分类 (binary classification) 是最简单的一种分类问题,

- 2018-07-08

前两节分别介绍了一个回归模型和一个分类模型,其中线性回归中假设概率分布为

- 2018-07-19

本节首先介绍函数间隔和几何间隔的概念,进而引出最优间隔分类器和拉格朗日对偶,最后介绍核函数和 SMO algorithm

- 2018-07-14

前面讲到的学习算法都是对

- 2018-08-04

感知机算法是 <统计学习方法> 这本书讲的第一个机器学习算法,据说是最简单的机器学习算法。这里参考书中的例子,使用程序实现该算法,以便加深理解。

预览: